Keras学習入門

はじめに

公式ドキュメントを読みましょう。

サンプルもあります。

https://github.com/keras-team/keras/tree/master/examples

参考にした記事

作りたいもの

適当な5次元のデータ配列を入力すると、その和が2.5より大きい場合に、1と教えてくれるニュートラルネットワークを作成します。

データセットを作る

適当なデータセットを作ります。以下は1000行、5列の2次元のデータを作成する。

random.randの1つ目の引数に行数、2つ目の引数に列数を指定します。

ここで、1つの行について考えると、列は5つあるため、1000個の5次元のデータを作成したと考えることもできます。

data = np.randam.rand(1000, 5)

array([[0.3940429 , 0.79998594, 0.58371434, 0.4746385 , 0.57960131],

[0.48199409, 0.29579691, 0.6393789 , 0.79172043, 0.35938036],

[0.32953348, 0.44838049, 0.60369065, 0.96091877, 0.61703259],

...,

[0.40231469, 0.69186734, 0.09979942, 0.57616445, 0.99702868],

[0.41718706, 0.92310164, 0.66852297, 0.69960452, 0.15955488],

[0.25724677, 0.94933856, 0.18957415, 0.22025431, 0.52682667]])

import numpy as np from keras.utils import np_utils # dataは5次元のデータ data = np.random.rand(1000, 5) # sum_dataは1次元のデータ sum_data = (np.sum(data, axis=1) > 2.5) * 1

データセットを整形する

one-hotなラベルを作成します。

one-hot(ワン・ホット)は1つだけHigh(1)であり、他はLow(0)であるようなデータのことです。

from keras.utils import np_utils sum_data = (np.sum(data, axis=1) > 2.5) * 1 labels = np_utils.to_categorical(sum_data)

array([[0., 1.],

[1., 0.],

[1., 0.],

...,

[0., 1.],

[1., 0.],

[0., 1.]], dtype=float32)

ニュートラルネットワークを作る

Sequentialは層を積み上げるだけのモデル。

今回は中間層(入力層・隠れ層・出力層)とする

入力5個、出力2個のニュートラルネットワークを作成します。

from keras.models import Sequential from keras.layers import Dense, Activation model = Sequential()

Denseというレイヤー(通常の全結合ニューラルネットワークレイヤー)を使用する。

5個のノートから、それぞれ10本矢印が出てきて、次の層のノードが10個であることを示す。 ノード数は入力データの次元数と一致する必要がある。

model.add(Dense(10, input_dim=5))

出力に活性化関数を適用します。'relu'はランプ関数です。

活性化関数は、入力信号の総和がどのように活性化するかを決定する役割を持ちます。

これは、次の層に渡す値を整えるような役割をします。

model.add(Activation('relu'))

次は隠れ層―出力層。10個のノードから(活性化関数が適用されたあと)それぞれ値がやってくる。出力は2次元で、ノードにやってきた10個の値に対して重み付き和とソフトマックス関数を使用します。

ソフトマックス関数は、活性化関数の1つで、出力層で使われる関数です。

model.add(Dense(2, activation='softmax'))

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

コンパイル

学習の前にコンパイルを行います。

1つめは最適化関数、2つめは損失関数、3つめは評価指標のリスト。

model.compile('rmsprop', 'categorical_crossentropy', metrics=['accuracy'])

学習

nb_epoch は回数。validation_split は検証に使うデータの割合(全体のデータを学習に使わず、8割のみを学習に使って、残りの2割を評価に使う)。

model.fit(data, labels, nb_epoch=300, validation_split=0.2)

未知データ予測

予測精度を判別します。

test = np.random.rand(1000, 5) ## 予測配列 predict = np.argmax(model.predict(test), axis=1) ## 正解配列 real = (np.sum(test, axis=1) > 2.5) * 1 sum(predict == real) / 1000.0

コード例

from keras.utils import np_utils

from keras.models import Sequential

from keras.layers import Dense, Activation

import numpy as np

data = np.random.rand(1000,5)

data_sum = (np.sum(data, axis=1) > 2.5) * 1

labels = np_utils.to_categorical(data_sum)

model = Sequential([Dense(10, input_dim=5), Activation('relu'), Dense(2, activation='softmax')])

model.compile('rmsprop', 'categorical_crossentropy', metrics=['accuracy'])

model.fit(data, labels, nb_epoch=100, validation_split=0.2)

test = np.random.rand(1000, 5)

predict = np.argmax(model.predict(test), axis=1)

real = (np.sum(test, axis=1) > 2.5) * 1

print(sum(predict == real) / 1000.0)

0.979

参考リンク

Pythonで画像データをFlickerで取得する

はじめに

Pythonで画像データを取得してみたいと思います。 flickr の画像取得は、flickr API を使用します。

flickrのAPIは以下に記載されています

https://www.flickr.com/services/api/

APIを使用して画像情報を取得してみる

flickrのAPIを使用して画像の情報を取得します。

コマンドプロンプト上から python [コードのファイル名] monkey と打つと画像情報を取得できます。

コード例

import flickrapi from urllib.request import urlretrieve from pprint import pprint import os, time, sys # APIキーの情報 key = "d21bac140e0245aed437c6c812f27d44" secret = "b5e79704c13a3d15" wait_time = 1 # コマンドライン引数の 1 番目の値を取得 animalname = sys.argv[1] # 画像を保存するディレクトリを指定 savedir = "./" + animalname flickr = flickrapi.FlickrAPI(key, secret, format='parsed-json') result = flickr.photos.search( # 検索キーワード text = animalname, # 取得するデータ件数 per_page = 2, # 検索するデータの種類(ここでは、写真) media = 'photos', # データの並び順(関連順) sort = 'relevance', # UI コンテンツを表示しない safe_search = 1, # 取得したいオプションの値(url_q->画像のアドレスが入っている情報、licence -> ライセンス情報) extras = 'url_q, licence' ) photos = result['photos'] # 戻り値を表示する # pprint(photos)

{'page': 1,

'pages': 498092,

'perpage': 2,

'photo': [{'farm': 4,

'height_q': '150',

'id': '15557905405',

'isfamily': 0,

'isfriend': 0,

'ispublic': 1,

'owner': '101295317@N06',

'secret': '05357b440d',

'server': '3928',

'title': 'monkey',

'url_q': 'https://live.staticflickr.com/3928/15557905405_05357b440d_q.jpg',

'width_q': '150'},

{'farm': 1,

'height_q': '150',

'id': '297887549',

'isfamily': 0,

'isfriend': 0,

'ispublic': 1,

'owner': '12345287@N00',

'secret': '2dc0ee273f',

'server': '110',

'title': 'monkey',

'url_q': 'https://live.staticflickr.com/110/297887549_2dc0ee273f_q.jpg',

'width_q': '150'}],

'total': '996183'}

次に、画像を実際にダウンロードします。

コマンドプロンプト上から python [コードのファイル名] monkey と打つと画像データがダウンロードされます。

コード例

import flickrapi from urllib.request import urlretrieve from pprint import pprint import os, time, sys # APIキーの情報 key = "d21bac140e0245aed437c6c812f27d44" secret = "b5e79704c13a3d15" wait_time = 1 # コマンドライン引数の 1 番目の値を取得 animalname = sys.argv[1] # 画像を保存するディレクトリを指定 savedir = "./" + animalname flickr = flickrapi.FlickrAPI(key, secret, format='parsed-json') result = flickr.photos.search( # 検索キーワード text = animalname, # 取得するデータ件数 per_page = 400, # 検索するデータの種類(ここでは、写真) media = 'photos', # データの並び順(関連順) sort = 'relevance', # UI コンテンツを表示しない safe_search = 1, # 取得したいオプションの値(url_q->画像のアドレスが入っている情報、licence -> ライセンス情報) extras = 'url_q, licence' ) photos = result['photos'] for i, photo in enumerate(photos['photo']): url_q = photo['url_q'] filepath = savedir + '/' + photo['id'] + '.jpg' # ファイルが重複していたらスキップする if os.path.exists(filepath): continue # データをダウンロードする urlretrieve(url_q, filepath) time.sleep(wait_time)

mnist手書き数字画像データ学習モデル活用でjpeg画像を予測します [Python]

はじめに

手書き文字の認識をNeuralnetworkを用いて行います。 Kerasから手書き文字のデータをダウンロードして、そのデータを用いて、NeuralnetworkのTrainingを行い、その後に下記のnumber_fileをTest dataとして数字の認識を実施します。

コード例

from keras import backend as K from keras.datasets import mnist from keras.layers import Activation, Dense, Dropout from keras.layers.normalization import BatchNormalization from keras.models import Sequential from keras.utils.np_utils import to_categorical import numpy as np from sklearn.metrics import classification_report, confusion_matrix # Kerasに付属の手書き数字画像データをダウンロード np.random.seed(0) (X_train, labels_train), (X_test, labels_test) = mnist.load_data() # Traning setのラベルを確認 labels_train # Training setの概要確認 print(X_train.shape, labels_train.shape, sep='\n') # Test setの概要確認 print(X_test.shape, labels_test.shape, sep='\n') # Training setの画像を表示 import matplotlib.pyplot as plt %matplotlib inline label_images = {label: [] for label in set(labels_train.tolist())} for x, label in zip(X_train, labels_train): if all(len(images) >= 10 for images in label_images.values()): break if len(label_images[label]) >= 10: continue label_images[label].append(x) for j, (label, images) in enumerate(label_images.items()): plt.subplot(10, 11, j * 11 + 1) plt.text(0.5, 0.5, label, ha='center', va='center') plt.axis('off') for i, image in enumerate(images): if i >= 10: continue plt.subplot(10, 11, j * 11 + i + 2) plt.imshow(image, cmap='Greys_r') plt.axis('off') plt.show() del label_images # Test dataの画像表示 label_images = {label: [] for label in set(labels_test.tolist())} for x, label in zip(X_test, labels_test): if all(len(images) >= 10 for images in label_images.values()): break if len(label_images[label]) >= 10: continue label_images[label].append(x) for j, (label, images) in enumerate(label_images.items()): plt.subplot(10, 11, j * 11 + 1) plt.text(0.5, 0.5, label, ha='center', va='center') plt.axis('off') for i, image in enumerate(images): if i >= 10: continue plt.subplot(10, 11, j * 11 + i + 2) plt.imshow(image, cmap='Greys_r') plt.axis('off') plt.show() del label_images ## 画像データを特微ベクトルに変換します # 各画像は行列なのでベクトルに変換→X_trainとX_testを作成 X_train = X_train.reshape(len(X_train), -1) X_test = X_test.reshape(len(X_test), -1) print(X_train.shape) print(X_train[:5]) # ラベルをone-hotベクトル(値がひとつだけ1で他が0のベクトル)に変換→Y_trainとY_testを作成 Y_train = to_categorical(labels_train) Y_test = to_categorical(labels_test) print(Y_train) print(Y_test) ## Deep learningの実施 # モデルの準備 model = Sequential() model.add(Dense(10, input_shape=(784,))) model.add(Activation('softmax')) model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy']) # Trainingの実施 model.fit(X_train, Y_train, batch_size=128, nb_epoch=10, verbose=1) # Test dataを用いてモデルを評価(accuracyを算出) _, acc = model.evaluate(X_test, Y_test, verbose=0) print('accuracy: {}'.format(acc)) # Classification_report関数で評価結果を表示 labels_pred = model.predict_classes(X_test, verbose=0) print(confusion_matrix(labels_test, labels_pred)) print(classification_report(labels_test, labels_pred)) # Training後のモデルを用いてnumber_file中の画像の数字を予測 # 必要なモジュールの読み込み import glob import os from PIL import Image (x_train, y_train), (x_test, y_test) = mnist.load_data() print(x_train.shape) print(y_train.shape) print(x_test.shape) print(y_test.shape) img_dir = 'number_file' os.makedirs(img_dir, exist_ok=True) # 全画像分を保存するようにする for data, label in zip(x_test[:1000], y_test[:1000]): img = Image.fromarray(data) # グレースケール形式で保存する。 img.save(os.path.join(img_dir, 'gray_{}.png'.format(label))) # RGB 形式で保存する。 img = img.convert('RGB') img.save(os.path.join(img_dir, 'color_{}.png'.format(label))) # フォルダ内の画像を読み込み、予測する。 for img_path in glob.glob(os.path.join(img_dir, '*.png')): # 画像を読み込む。 img = Image.open(img_path) # 画像が RGB ならグレースケールに変換する。(28, 28, 3) -> (28, 28) if img.mode == 'RGB': img = img.convert("L") # 行列を1次元に変換する(28, 28) -> (1, 784) にする。 data = np.array(img).reshape(1, -1) # データをモデルに入れて予測 pred_y = model.predict_classes(data, verbose=0) print(img_path, pred_y)

主な出力イメージ

accuracy: 0.9061

[[ 961 0 2 3 0 3 8 1 2 0]

[ 0 1091 25 3 1 1 3 2 9 0]

[ 3 0 967 5 16 3 7 9 19 3]

[ 4 0 56 870 4 37 1 8 21 9]

[ 2 1 8 0 933 0 9 2 8 19]

[ 11 1 15 23 24 762 10 6 36 4]

[ 14 1 28 0 12 25 867 1 10 0]

[ 2 5 33 4 15 0 0 943 4 22]

[ 5 3 36 12 20 19 3 16 856 4]

[ 9 4 2 9 109 15 1 33 16 811]]

precision recall f1-score support

0 0.95 0.98 0.97 980

1 0.99 0.96 0.97 1135

2 0.83 0.94 0.88 1032

3 0.94 0.86 0.90 1010

4 0.82 0.95 0.88 982

5 0.88 0.85 0.87 892

6 0.95 0.91 0.93 958

7 0.92 0.92 0.92 1028

8 0.87 0.88 0.88 974

9 0.93 0.80 0.86 1009

micro avg 0.91 0.91 0.91 10000

macro avg 0.91 0.90 0.91 10000

weighted avg 0.91 0.91 0.91 10000

number_file\color_0.png [0]

number_file\color_1.png [1]

number_file\color_2.png [2]

number_file\color_3.png [3]

number_file\color_4.png [4]

number_file\color_5.png [5]

number_file\color_6.png [6]

number_file\color_7.png [7]

number_file\color_8.png [8]

number_file\color_9.png [9]

number_file\gray_0.png [0]

number_file\gray_1.png [1]

number_file\gray_2.png [2]

number_file\gray_3.png [3]

number_file\gray_4.png [4]

number_file\gray_5.png [5]

number_file\gray_6.png [6]

number_file\gray_7.png [7]

number_file\gray_8.png [8]

number_file\gray_9.png [9]

参考リンク

Python - mnist手書き数字画像データ学習モデル活用でjpeg画像の予測ができません。|teratail

深層学習 TensorFlow を MNIST で試す(2) | ecobioinfo.com – 環境・生物・情報処理 -

GraphViz'sで可視化する (Windows)

はじめに

Windowsで、GraphViz'sで可視化する場合は大変です。

環境

- Python 3.6

手順

(1) Anaconda Promptで、以下のようにgraphvizとpydotをインストール

conda install graphviz

pip install pydotplus

(2) graphvizを公式ホームページからインストールしてください。

(3) システム環境パスを通すか、もしくは直接コードにパスを埋め込みます。(本例は後者)

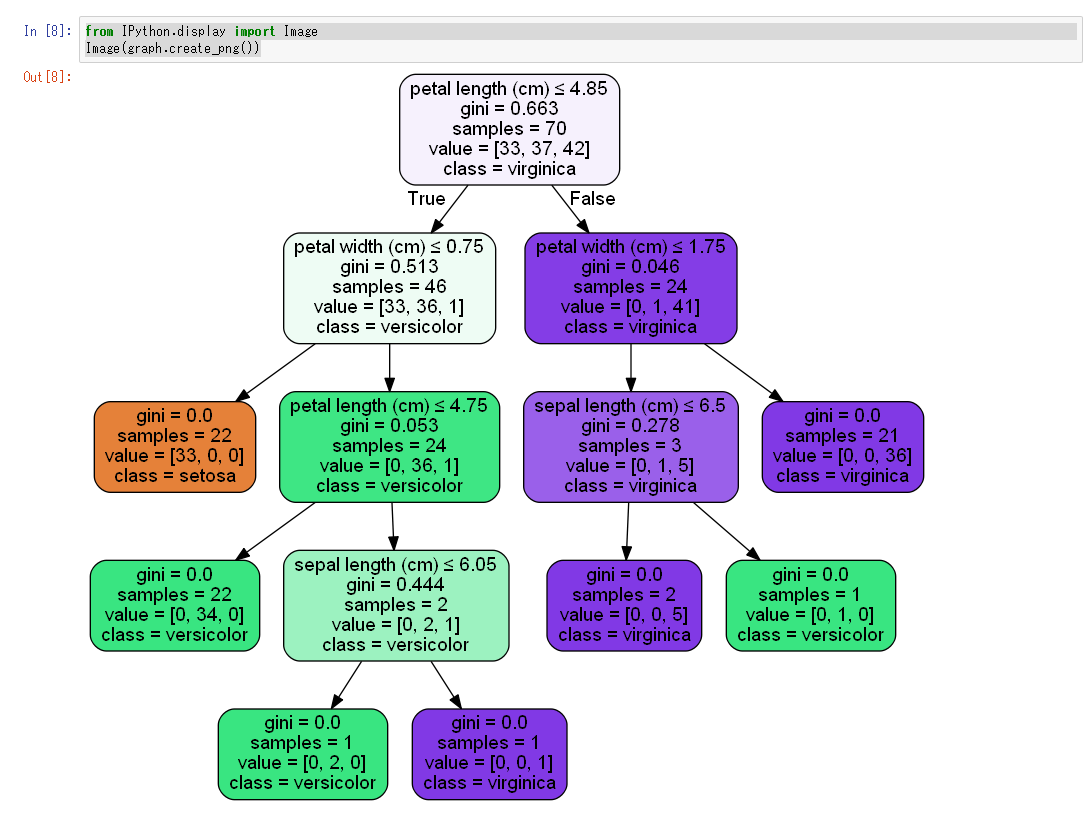

u""" 決定木系モデルを視覚化する。 Graphviz を用いて、決定木のモデルを視覚化する。 決定木だけでなく、ランダムフォレストなど木構造のモデルに適用できる。 """ from sklearn.datasets import load_iris from sklearn.ensemble import RandomForestClassifier from sklearn.model_selection import train_test_split from sklearn.model_selection import cross_val_score # モデルの木構造の視覚化に必要なパッケージ from sklearn import tree import pydotplus as pdp import pandas as pd import numpy as np # パスを手動で追加します (システムの環境設定を通してもうまくいかなかったため、パスを仕方なく追加しました。) # InvocationException: GraphViz's executables not found import os os.environ["PATH"] += os.pathsep + "C:/Users/uv2ut/Anaconda3/Library/bin/graphviz" iris = load_iris() df = pd.DataFrame(iris.data, columns=iris.feature_names) print(df.head(5)) print(iris.target) print(iris.target_names) df['species'] = pd.Categorical.from_codes(iris.target, iris.target_names) print(df.head(5)) # 学習データとテストデータを分ける features = df.columns[:4] label = df["species"] print(features) print(label) print(df[features].head(5)) df_train, df_test, label_train, label_test = train_test_split(df[features], label) clf = RandomForestClassifier(n_estimators=150) clf.fit(df_train, label_train) print("========================================================") print("予測の精度") print(clf.score(df_test, label_test)) # 試しに木の一つを視覚化する estimators = clf.estimators_ file_name = "./tree_visualization.png"

dot_data = tree.export_graphviz(estimators[0], # 決定木オブジェクトを一つ指定する out_file=None, # ファイルは介さずにGraphvizにdot言語データを渡すのでNone filled=True, # Trueにすると、分岐の際にどちらのノードに多く分類されたのか色で示してくれる rounded=True, # Trueにすると、ノードの角を丸く描画する。 feature_names=features, # これを指定しないとチャート上で特徴量の名前が表示されない class_names=iris.target_names, # これを指定しないとチャート上で分類名が表示されない special_characters=True # 特殊文字を扱えるようにする ) graph = pdp.graph_from_dot_data(dot_data) # 以下の命令で、ipynbと同じフォルダに、fileNameの画像ファイルが保存されます。 graph.write_png(file_name)

from IPython.display import Image Image(graph.create_png())

表示イメージ

リンク

- GraphViz'sのWindowsでのインストール方法 windowsでkerasの可視化の際の注意点 [サルでもわかる機械学習]

あとがき

システム環境設定のパスが重要らしい

仮想環境を利用しているときは下記のgraphvizのフォルダパスをPathに追加します。 C:\Users\ユーザー名\Anaconda3\envs\仮想環境名\Library\bin\graphviz 仮想環境を利用していないときは下記のgraphvizのフォルダパスをPathに追加します。 C:\Users\ユーザー名\Anaconda3\Library\bin\graphviz

TensorFlow GPU導入 [Windows 10] [tensorflow-gpu : version 1.8.0] [GPU : GEFORCE RTX 2060]

本記事の前に

Windows環境のTensorFlow GPU導入方法は、

以下の国立研究開発法人 産業技術総合研究所 安全科学研究部門様の記事がとてもわかりやすいです。

WindowsでKerasを用いたDeep Learning開発環境を整備する | 産総研:安全科学研究部門– 持続可能な社会実現に向けた評価研究部門 | 産総研 AIST RISS

本記事について

Windows環境へのTensorFlow GPUに非常に苦労したため、記事にします。

この記事では、tensorflow-gpu : verseion 1.8.0を扱います。

最新のtensorflow-gpuバージョンを取り扱ったものではありません。

本記事は、以下のSamurai Blog様の2018年度版】TensorFlow 1.5のインストール方法を解説!【Windows 10】の情報を参考に作成しました。

【2019年度版】TensorFlow 1.5のインストール方法を解説!【Windows 10】 | 侍エンジニア塾ブログ(Samurai Blog) - プログラミング入門者向けサイト

注意事項

CUDA、cuDNN 、tensorflow-gpuのバージョンの組み合わせがとても重要です。正しい組み合わせでなければ、tensorflow-gpuが正常に動作しません。

詳細は、Qiitaの記事(NvidiaドライバとCUDAとcuDNNとTensorflow-gpuとPythonのバージョンの対応)をご確認ください。

NvidiaドライバとCUDAとcuDNNとTensorflow-gpuとPythonのバージョンの対応 - Qiita

Build from source on Windows | TensorFlow

構築環境

本記事では、TensorFlow GPU環境は、Anaconda3の仮想環境上に作成します。以下、環境情報です。

- OS : Windows 10

- GPU : GEFORCE RTX 2060 GAMING Z

- tensorflow-gpu : verseion 1.8.0

- CUDA : version 9.0

- cuDNN : version 7.4

- Python 3.6 (Python 3.7ではtensorflow-gpuが動きません) (Anaconda 3で仮想環境を作成するときに、Python versionを3.6に指定します)

手順

GPUのドライバーはインストール済みであることが前提条件です。

また、TensorFlow GPU環境は、Anaconda3の仮想環境上に作成します。

(1) まず、visual_studio_community_2015_with_update_3のインストールが必要です。CUDAのインストールに必要であるためです。(参考リンク参照)

ja_visual_studio_community_2015_with_update_3_x86_x64_web_installer_8922964.exe

(2) 次に、CUDAのインストールを行います。必ずベースファイルからインストールしてください。 (本例では、cuda_9.0.176_win10_network.exeがベースファイル)

ベースファイルインストール途中でエラーが発生しますが、GPUのドライバーを古いドライバーで上書きしようとしています。

GPUドライバーのインストールのみ、チェックを外せば問題ありません。(参考リンク参照)

その後、パッチを順番に4つインストールします。

- cuda_9.0.176_win10_network.exe

- C:\Users\uv2ut\Downloads\cuda_9.0.176.1_windows.exe

- C:\Users\uv2ut\Downloads\cuda_9.0.176.2_windows.exe

- C:\Users\uv2ut\Downloads\cuda_9.0.176.3_windows.exe

- C:\Users\uv2ut\Downloads\cuda_9.0.176.4_windows.exe

(3) 次に、cuDNN (Version 7.4)をインストールします。参考リンク参照

- cudnn-9.0-windows10-x64-v7.4.2.24.zip

(4) Anaconda Promptで、まず仮想環境を作成します。

conda create -n tensorflow-gpu python=3.6

activate tensorflow-gpu

次に、各モジュールをインストールします。

モジュールのバージョンに気を付けてください。 (特にtensorflow-gpuとkeras-gpu)

また、コマンドの実行順序も影響するため、以下の順に入力してください。

pip install --upgrade pip conda install pandas matplotlib jupyter notebook scipy scikit-learn scikit-image h5py seaborn pip install opencv-python conda install tensorflow-gpu==1.8.0 conda install keras-gpu==2.1.6

動作確認

jupyter notebook上で確認するとよいと思います。

import tensorflow as tf hello = tf.constant('Hello, TensorFlow!') sess = tf.Session() print(sess.run(hello)) sess.close()

b'Hello, TensorFlow!'

古いマザーボード(Z77X-UD3H)に新しいグラフィックボード(GEFORCE RTX-2060 GAMING Z )を搭載してみた

はじめに

高速なGPUが欲しかったので、古いマザーボード(Z77X-UD3H)に新しいグラフィックボード(GEFORCE RTX-2060 GAMING Z )を搭載してみました。

新しいグラフィックボードを起動するのに、一晩かかりましたので、展開します・・・。

手順

Z77などの70番台のマザーボードで最新のグラフィックボードを乗せようとすると、マザーボードとグラフィックボードとの間の相性問題がおきやすいらしいです。

私は、グラフィックボードをPCに接続すると、電源をいれても全く画面が移りませんでした・・・。なお、電源容量が足りていました。

私の解決方法は以下でできました。

(1) BIOSのアップデート

私は、以下のサイトを見ながら、Q-FlashによるUEFIアップデートを行いました。

GIGABYTE製マザーボードのUEFI(BIOS)アップデート

(2) BIOS画面でPCI ROM Priority の設定をEFI Compatible ROM→Legacy ROMへ変更しました。

グラボが認識できません。BIOS設定教えてください。 -当方のシステムは- ビデオカード・サウンドカード | 教えて!goo

マザーボード情報

あとがき

最新のグラフィックボードを使用したい場合は、新しいマザーボードを使用したほうがトラブルは少ないと思います。

参考情報

以下、ツクモ福岡店の最新情報ブログからの情報

最新のグラフィックボードを増設しようとしているパソコンやマザーボードが2012年頃に購入している製品の場合は注意が必要です。 ある世代以降のグラフィックボードが使用できない可能性があります。

具体的には下記の様な症状が発生します。 「画面が全く映らない」 「BIOSメニューには入れるがOSの起動には至らない」 「電源を入れ、メーカーのロゴが表示されたまま先に進まない」 「画面左上でアンダーバーが点滅表示されたまま先に進まない」

この問題はマザーボードとグラフィックボードの双方のBIOSに起因しています。 「ファストブート」や「セキュアブート」といった新しい機能に対応していくために、グラフィックボードのBIOSが「UEFI」方式へと切り替わって移行が進んでいます。 このUEFI方式のBIOSを搭載したグラフィックボードと、2012年頃に販売されていたパソコンやマザーボードとの組み合わせで多数の不具合報告が上がっています。

▼特に症例報告が多いマザーボード(チップセット) インテルP67・Z68などの60番台および、H77・Z77・X79など70番台チップセットを搭載しているマザーボード